Warum die richtige IT-Infrastruktur entscheidend für deinen KI-Erfolg ist

Wenn du in deinem Unternehmen den effektiven Einsatz von KI-Technologien planst, wirst du früher oder später auf ein zentrales Thema stoßen: die IT-Infrastruktur. Unsere Erfahrung zeigt, dass genau hier über Erfolg oder Frust entschieden wird. Denn moderne Künstliche Intelligenz funktioniert nur so gut wie die Infrastruktur, die sie trägt. Und nein – eine schnelle Cloud-Verbindung allein reicht dafür längst nicht mehr aus.

Wir bei peterkrause.net begleiten Unternehmen aus Deutschland, Österreich und der Schweiz täglich bei der technischen Umsetzung von agentiven KI-Lösungen. Dabei sehen wir immer wieder dieselben Herausforderungen: veraltete IT-Strukturen, fehlende Skalierbarkeit, unterschätzte Datenanforderungen. Genau deshalb legen wir den Fokus auf eins: Deine KI braucht eine Infrastruktur, die mitdenkt – robust, skalierbar, sicher.

„Generative KI zu nutzen ist leicht – aber echte KI zu implementieren heißt: Infrastruktur neu denken.“

Was dich in diesem Artikel erwartet

In diesem Artikel bekommst du kein technisches Blabla – sondern klare Antworten auf Fragen wie:

- Welche Infrastrukturkomponenten braucht eine produktive KI-Umgebung wirklich?

- Was sind typische Engpässe bei der Rechenleistung und Datenintegration?

- Wie unterscheiden sich Anforderungen für Cloud, On-Premise oder hybride KI-Modelle?

- Was musst du beachten, um deine KI-Systeme effizient, sicher und skalierbar zu betreiben?

Wir zeigen dir, worauf es bei der Implementierung von KI in der Praxis ankommt, und wie du deine IT-Infrastruktur so vorbereitest, dass sie dich nicht limitiert – sondern Innovation, Wachstum und Wettbewerbsvorteile ermöglicht.

Für wen wir schreiben

Dieser Artikel ist für alle, die KI nicht nur testen, sondern wirklich in ihren Geschäftsprozessen implementieren wollen – ganz gleich ob im Marketing, in der Produktion, im Kundenservice oder im Management. Wir sprechen Unternehmer:innen, Innovationsverantwortliche und IT-Leiter:innen an, die sich nicht mit Tools zufriedengeben, sondern agentive KI ganzheitlich denken.

Im nächsten Abschnitt erfährst du, was eine moderne KI-fähige IT-Infrastruktur ausmacht – und warum Standardlösungen oft nicht ausreichen.

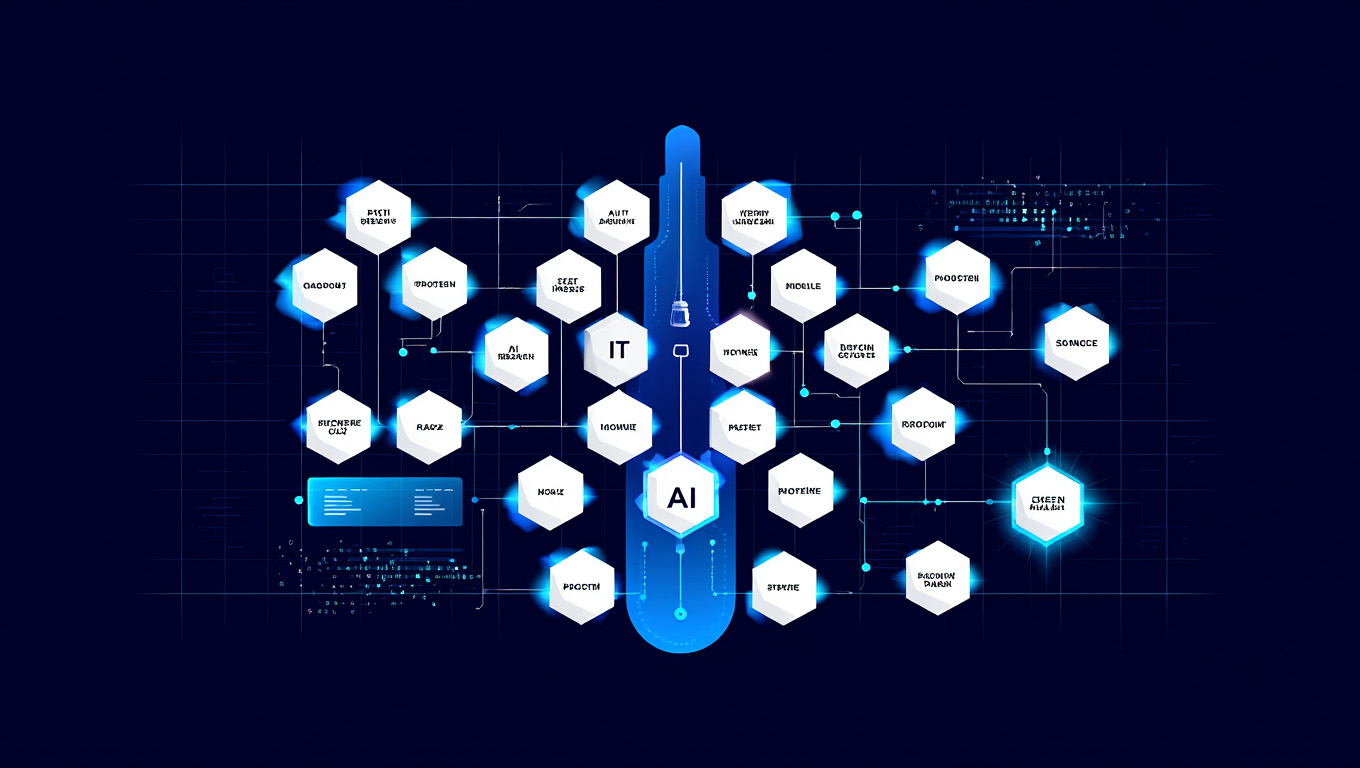

Was versteht man unter einer KI-fähigen IT-Infrastruktur?

Eine KI-fähige IT-Infrastruktur ist weit mehr als eine Sammlung moderner Server oder ein schneller Internetzugang. Sie ist die technologische Grundlage, auf der alle KI-Anwendungen, -Modelle und -Prozesse laufen – und sie muss dafür optimiert, belastbar und skalierbar sein. Besonders dann, wenn du agentive Systeme wie Custom AI Agents integrieren willst, ist eine intelligente Infrastruktur nicht optional, sondern absolut entscheidend.

Wie unterscheiden sich klassische IT-Infrastrukturen von KI-Infrastrukturen?

In klassischen Unternehmensumgebungen liegt der Fokus meist auf Stabilität, Sicherheit und Kosteneffizienz. Doch KI verlangt nach etwas anderem: Rechenleistung, Datendurchsatz und Flexibilität. Herkömmliche Architekturen stoßen hier schnell an ihre Grenzen.

| Typische IT-Infrastruktur | KI-Infrastruktur |

|---|---|

| Optimiert für Office-, ERP- oder CRM-Systeme | Optimiert für rechenintensive KI-Workloads und Datenströme |

| Statische Rechenressourcen | Skalierbare GPUs und dynamische Cloud-Kapazitäten |

| Datenzugriff über strukturierte Schnittstellen | Echtzeit-Verarbeitung großer Datenmengen aus verschiedenen Quellen |

Unsere Erfahrung zeigt: Wer einfach versucht, KI in bestehende Strukturen zu quetschen, verliert – an Performance, Qualität und letztlich auch an Vertrauen im Team.

Welche Komponenten sind für den Betrieb von KI-Systemen unverzichtbar?

Damit KI-Systeme performen, brauchst du eine solide Kombination aus:

- Skalierbarer Rechenleistung: v. a. GPUs für das Training und die Ausführung von KI-Modellen

- Schneller Datenspeicherung: SSDs mit hoher IOPS-Leistung zur Verarbeitung großer Datenmengen

- Datenintegrationstools: um strukturierte und unstrukturierte Datenquellen zusammenzuführen

- Monitoring & Observability: zur Überwachung der Infrastruktur und automatischen Skalierung

Ohne diese Basiselemente wirst du KI nicht stabil und effizient bereitstellen können – und Projekte scheitern oft genau hier, bevor sie überhaupt starten.

Welche Rolle spielt die Rechenleistung in modernen KI-Anwendungen?

Ganz klar: Rechenleistung ist das Rückgrat jeder KI-Implementierung. Egal ob du einen Language Model wie GPT4-o einbindest oder dein eigenes KI-Modell trainierst – du brauchst Zugriff auf spezialisierte Ressourcen. Dabei geht es nicht nur um Mengen an Rechenleistung, sondern auch um:

- Verfügbarkeit: Skalierbar – auch kurzfristig bei Peak-Loads

- Verarbeitungsgeschwindigkeit: Geringe Latenzzeiten – besonders bei Echtzeitanwendungen

- Kosten-Nutzen-Faktor: Intelligente Ressourcennutzung zur Vermeidung unnötiger Ausgaben

Wir setzen hier häufig auf Kombinationen aus dedizierten GPU-Nodes, Edge-Komponenten und Cloud-Diensten wie Azure, AWS oder Digital Realty, je nach Projektanforderung.

„Ohne skalierbare Infrastruktur ist jede KI nur ein Proof of Concept. Mit der richtigen Basis wird sie zum Gamechanger.“

Im nächsten Abschnitt zeigen wir dir, welche konkreten Voraussetzungen du schaffen musst, um KI erfolgreich zu implementieren – von der Datenstruktur bis zur Cloud-Architektur.

Welche Voraussetzungen müssen Unternehmen für KI-Implementierung schaffen?

Viele Unternehmen haben verstanden, dass Künstliche Intelligenz enorme Potenziale bietet – von der Automatisierung repetitiver Prozesse bis hin zur datenbasierten Entscheidungsfindung. Doch bevor man mit der Implementierung beginnt, braucht es eine solide Basis. Unsere Erfahrung zeigt: Die größten Probleme entstehen dort, wo technologische Infrastruktur und operative Realität auseinanderklaffen. Hier erfährst du, worauf du achten musst.

Welche Anforderungen an Datenspeicherung und Datenintegration entstehen durch KI?

Für KI-Systeme sind Daten der wichtigste Rohstoff. Aber nicht nur die Menge zählt – sondern Struktur, Qualität und Geschwindigkeit der Verarbeitung. Besonders wichtig ist:

- Datenintegration: Du musst Daten aus verschiedenen Quellen (z. b. ERP, CRM, Website, Social Media) strukturiert zusammenführen können.

- Datenspeicherung: Die Infrastruktur muss in der Lage sein, große, oft unstrukturierte Datenmengen schnell zu speichern, zu indexieren und abrufbar zu machen.

- Datenintegrität: Fehlerhafte oder inkonsistente Daten führen zu falschen Ergebnissen – insbesondere bei generativen oder lernenden Systemen.

Unternehmen sollten sicherstellen, dass ihre Daten aktuell, konsistent und abrufbereit sind – sonst wird jede KI-Implementierung ineffizient oder sogar fehleranfällig.

Welche Rolle spielt die Cloud bei der Skalierbarkeit von KI-Infrastrukturen?

Die Cloud hat sich in der Praxis als Schlüsseltechnologie für moderne KI-Infrastruktur etabliert – insbesondere für Unternehmen, die nicht in eigene Rechenzentren investieren wollen oder können. Ihre Vorteile:

- Skalierbarkeit: Ressourcen können bei Bedarf dynamisch hoch- oder runtergefahren werden

- Flexibilität: Cloud-Dienste wie AWS, Azure oder Google Cloud bieten spezialisierte KI-Services und APIs out-of-the-box

- Kostenkontrolle: Bezahlt wird nur, was tatsächlich genutzt wird – sinnvoll bei projektbasierten Modellen

Aber Achtung: Wer mit arbeitet oder DSGVO-konform bleiben muss, sollte auf setzen – oder agentive Systeme direkt „on premise“ betreiben.

Was bedeutet eine flexible und skalierbare Architektur konkret?

Wenn wir mit Kunden an der technologischen Infrastruktur für KI-Implementierung arbeiten, setzen wir immer auf ein Prinzip: **Flexibilität + Skalierbarkeit + Sicherheit**. Konkret bedeutet das:

- Modularität: Jede Komponente (z. b. Storage, Compute, Netzwerk) kann unabhängig erweitert oder ersetzt werden

- Edge-Fähigkeit: Anwendungen, die geringe Latenz erfordern (z. b. Echtzeit-Entscheidungen), laufen näher am Endgerät

- APIs & Schnittstellen: Deine KI-Systeme müssen sich in bestehende Workflows integrieren lassen – ohne Medienbrüche

Eine solche Architektur stellt sicher, dass du auch in Zukunft neue KI-Modelle, Produkte und Services effizient bereitstellen kannst – ohne jedes Mal alles neu zu bauen.

„Je flexibler deine Infrastruktur, desto schneller kannst du Innovationen skalieren – das ist der Unterschied zwischen Early Mover und Follower.“

Im nächsten Abschnitt gehen wir ins Technische: Welche Tools, Technologien und Ressourcen brauchst du konkret, um deine KI-Systeme performant und sicher zu betreiben?

Welche Technologien und Ressourcen sind für den Betrieb von KI-Lösungen notwendig?

Du kannst die beste KI-Idee der Welt haben – aber ohne die passende technologische Basis wird sie nie Realität. In der Praxis sehen wir immer wieder: Unternehmen investieren in KI-Strategien, ohne vorher die benötigte Infrastruktur zu verstehen. Dabei ist klar: Agentive KI braucht Rechenleistung, Integrationstiefe und technologische Souveränität. Hier erfährst du, welche Komponenten wirklich zählen.

Welche Bedeutung haben GPUs und spezialisierte Hardware für KI-Modelle?

KI-Modelle – insbesondere generative KI oder große Sprachmodelle – sind extrem rechenintensiv. Normale Server oder CPUs reichen da nicht aus. Stattdessen brauchst du:

- GPUs (Graphics Processing Units): für parallele Verarbeitung und schnelles Training von Modellen

- TPUs (Tensor Processing Units): spezialisierte Hardware für Deep Learning, besonders bei Google Cloud

- Edge Devices: Für Anwendungen mit minimaler Latenzzeit, z. b. im IoT- oder Produktionsumfeld

Besonders bei agentiven Systemen, die kontinuierlich mit Daten interagieren, ist es essenziell, die richtigen Rechenkapazitäten bereitzustellen – lokal, in der Cloud oder hybrid.

Welche Softwareumgebungen und Programmiersprachen wie Python sind essenziell?

Auf der Softwareseite brauchst du eine Umgebung, die modular, offen und erweiterbar ist. Zu den wichtigsten Technologien gehören:

- Python: Der Standard für KI-Entwicklung – stark in Machine Learning, NLP und Datenanalyse

- TensorFlow / PyTorch: Frameworks zur Entwicklung und zum Training komplexer KI-Modelle

- Docker / Kubernetes: Für Containerisierung und das effiziente Ausrollen von KI-Modellen

Für Unternehmen mit proprietären IT-Systemen gilt: Die Interoperabilität mit bestehenden Tools muss gegeben sein – ansonsten entstehen teure Insellösungen ohne Skalierungspotenzial.

Wie beeinflusst die Wahl von OpenAI, Azure oder AWS die Infrastrukturplanung?

Viele Unternehmen denken beim Thema KI sofort an Cloud-Dienste – und das zu Recht. Anbieter wie Azure, AWS oder Google Cloud bieten:

- Fertige KI-Modelle (z. b. GPT via OpenAI API), die schnell einsetzbar sind

- Serverless-Infrastruktur für dynamische Skalierung und geringe Wartungskosten

- Monitoring-, Logging- und Sicherheitsfunktionen auf Enterprise-Niveau

Die Entscheidung für einen Anbieter hängt ab von:

- Deinen (Stichwort DSGVO)

- Den im Unternehmen – z. b. Microsoft 365 → Azure-Nutzung sinnvoll

- Deinen

Wir empfehlen oft eine hybride Strategie: zentralisierte Daten und Modelle in der Cloud – sensible oder reaktive Prozesse lokal via Edge & Private Cloud.

„KI lebt nicht im Vakuum – sie lebt in deiner Infrastruktur. Und die entscheidet, wie viel du wirklich aus deinen Daten machst.“

Im nächsten Abschnitt zeigen wir dir, welche Stolperfallen es bei der Bereitstellung von KI-Infrastruktur gibt – und wie du sie mit klarer Planung vermeidest.

Welche Herausforderungen entstehen bei der Bereitstellung von KI-Infrastruktur?

Sobald Unternehmen ihre KI-Systeme bereitstellen wollen, prallen Theorie und Realität oft frontal aufeinander. Die PowerPoint-Präsentation ist perfekt – aber der erste KI-Agent läuft nicht. Warum? Weil die nötige Infrastruktur zu spät mitgedacht wurde oder operative Details unterschätzt wurden. Hier zeigen wir dir die häufigsten Stolpersteine – und wie du sie vermeidest.

Wie gehen Unternehmen mit steigenden Datenmengen und Datenquellen um?

Moderne KI lebt von Daten – aber je größer und komplexer die Systeme werden, desto schwieriger wird es, den Überblick zu behalten. Typische Herausforderungen sind:

- Datenintegration: Daten aus verschiedenen Quellen müssen konsistent, aktuell und abrufbar sein

- Datenvolumen: KI-Modelle benötigen riesige Datenmengen – und das schnell und parallel

- Datensicherheit: Besonders bei sensiblen Unternehmensdaten oder personenbezogenen Informationen ist DSGVO-Konformität Pflicht

Lösung: Setze auf eine , z. b. mit Data Lakes, automatisiertem ETL und zentralem Zugriffskonzept.

Was sind typische Engpässe bei Rechenzentren und deren Überwachung?

Ob On-Premise oder Cloud: Deine Rechenleistung ist nur so gut wie die Infrastruktur dahinter. Häufige Probleme sind:

- Veraltete Hardware: Reicht nicht aus für Deep Learning oder große Sprachmodelle

- Überlastung: KI-Workloads belasten Speicher, Netzwerke und CPUs deutlich stärker als klassische Anwendungen

- Mangelnde Transparenz: Ohne umfassendes Monitoring weißt du nicht, wo Flaschenhälse entstehen

Wir empfehlen in unseren Projekten immer: Monitoring-First-Ansatz – bevor etwas ausfällt, musst du es sehen. Tools wie Grafana, Prometheus oder spezialisierte Cloud-Dashboards helfen enorm.

Welche Risiken entstehen durch unzureichende Datenintegrität und Latenzzeiten?

Es braucht nicht viel, damit ein KI-System „falsch“ arbeitet – oft reichen:

- inkonsistente Datensätze, etwa durch Versionskonflikte

- Latenzprobleme bei cloudbasierten Inferenzen in Echtzeit-Umgebungen

- fehlende Redundanz, z. b. bei der Netzwerkstruktur oder dem Speicherzugriff

Gerade wenn du mit arbeitest, die Entscheidungen in Echtzeit treffen sollen (z. b. im Vertrieb, Service oder Logistik), kann eine zu hohe Latenz oder ein instabiler Datenpfad dazu führen, dass die Systeme:

- langsam reagieren

- Fehler produzieren

- das Vertrauen deiner Nutzer verlieren

„Wer auf KI setzt, muss auch auf Infrastrukturqualität setzen – alles andere ist ein Spiel mit dem Vertrauen der Nutzer.“

Im nächsten Abschnitt zeigen wir dir, wie du mit gezielten Maßnahmen die Effizienz deiner KI-Umgebung steigern kannst – und aus einer technischen Plattform einen echten Innovationsmotor machst.

Wie lässt sich Effizienz durch intelligente Infrastruktur steigern?

Viele Unternehmen unterschätzen den Hebel, den eine durchdachte IT-Infrastruktur auf die Effizienz von KI-Systemen hat. Dabei entscheiden Sekunden, Latenzen und Workload-Management darüber, ob deine Agenten flüssig laufen – oder frustrieren. In unseren Projekten sehen wir immer wieder: Es sind die kleinen Infrastrukturdetails, die große Wirkung entfalten. Hier zeigen wir dir die wichtigsten Stellschrauben.

Wie optimieren Unternehmen ihre Infrastruktur für KI-Workloads?

Der Schlüssel liegt in einer Architektur, die nicht nur „läuft“, sondern auf Leistung unter KI-Belastung ausgelegt ist. Unsere Empfehlung:

- KI-spezifisches Ressourcenmanagement: Workloads nach Modelltyp priorisieren (z. b. Batch vs. Echtzeit)

- Automatisierte Skalierung: Systeme wie Kubernetes ermöglichen Load-Balancing bei gleichzeitiger Ressourcenschonung

- Cache-Strategien: Schneller Zugriff auf wiederkehrende Daten spart Rechenzeit und beschleunigt inferenzbasierte Modelle

Gerade bei generativer KI oder agentiven Architekturen kann die clevere Kombination aus CPU-, GPU- und Speicherverteilung massive Performance-Gewinne bringen – ohne zusätzliche Kosten.

Welche Rolle spielt Edge Computing bei zeitkritischen Anwendungen?

Wenn du KI dort einsetzen willst, wo in Sekundenbruchteilen Entscheidungen getroffen werden müssen – z. b. in Maschinen, Logistikprozessen oder Kundeninteraktionen – dann brauchst du Edge-Strategien. Vorteile:

- Niedrige Latenz: Verarbeitung direkt am Ort des Geschehens, ohne Umweg über zentrale Rechenzentren

- Höhere Ausfallsicherheit: Lokale Logik funktioniert auch ohne Internetverbindung

- Datenschutzfreundlich: Sensible Daten verlassen das Gerät nicht

Microsoft Edge, Nvidia Jetson oder Raspberry PI mit Open Source KI-Lösungen – wir haben bereits realisiert.

Welche Zeit- und Kostenvorteile bringt eine gut geplante KI-Infrastruktur?

Wenn deine Infrastruktur sauber geplant ist, profitierst du mehrfach:

- Weniger Overhead: Systeme skalieren nur, wenn sie müssen → echte Kosteneffizienz

- Weniger Fehler: Automatisiertes Monitoring erkennt Probleme früh → weniger Ausfälle

- Weniger Zeitverlust: Schnellere Inferenz, automatisierte Prozesse → bessere User Experience

Im Alltag bedeutet das: Deine Agenten antworten schneller, dein Team hat mehr Vertrauen in die Systeme, deine Kunden erleben . All das zahlt auf deinen ROI ein.

„KI-Infrastruktur ist kein Kostenblock – sie ist ein strategischer Hebel zur Wertschöpfung.“

Im nächsten Abschnitt erklären wir dir, warum eine starke IT-Infrastruktur nicht nur Leistung bringt, sondern dein Wettbewerbsvorteil im KI-Zeitalter sein kann – und wie du sie strategisch nutzt.

Warum ist Infrastruktur der Schlüssel zu Innovation und Wettbewerbsvorteil?

Es gibt einen simplen Grund, warum manche Unternehmen bei der Einführung von KI große Sprünge machen – während andere nach Proof of Concept steckenbleiben: Infrastruktur als strategisches Asset. Wer seine technologische Infrastruktur nur als IT-Kostenstelle betrachtet, verpasst die Chance, sie als Motor für Innovation, Skalierung und Differenzierung zu nutzen.

Wie fördert eine moderne Infrastruktur die Entwicklung neuer KI-Produkte und -Dienstleistungen?

Wenn du eine robuste, flexible und skalierbare KI-Infrastruktur hast, kannst du:

- Schnell neue Ideen testen: Infrastruktur stellt sofort Rechenkapazitäten und Speicher bereit

- Agenten-Architekturen iterativ entwickeln: statt monolithischer Software – modulare, lernfähige Systeme

- Kundenzentrierte Innovationen bauen: z. b. individualisierte Empfehlungssysteme, Chatbots oder prädiktive Services

Ein gutes Beispiel: Unternehmen mit agentiver KI-Infrastruktur können Prototypen in Stunden statt Wochen launchen – das ist echte digitale Geschwindigkeit.

Welche Rolle spielt Infrastruktur für die Skalierung generativer KI?

Viele Unternehmen unterschätzen, wie unterschiedlich die Anforderungen bei der Skalierung sind. Während klassische Softwareanwendungen meist linear wachsen, explodieren bei :

- Rechenaufwand: insbesondere bei Sprach- und Bildverarbeitung

- Speicherbedarf: durch Trainingsdaten, Model States und Logs

- Sicherheitsrisiken: etwa durch unkontrollierte API-Aufrufe oder datenschutzrechtliche Verstöße

Deshalb braucht es , die nicht nur kurzfristig funktionieren, sondern dauerhaft skalierbar und auditierbar sind – auch bei plötzlichem Nutzerzuwachs oder neuen KI-Modellen.

Warum wird die technologische Infrastruktur zu einem strategischen Asset?

Unternehmen mit einer zukunftsfähigen KI-Infrastruktur…

- … können schneller umsetzen

- … treffen durch datenbasierte Erkenntnisse

- … sichern sich

Infrastruktur ist damit nicht nur der technische Unterbau – sie ist im Markt. Wer sie ignoriert, verliert. Wer sie meistert, gewinnt Spielraum, Schnelligkeit und Souveränität.

„Wettbewerbsvorteile entstehen dort, wo andere noch konfigurieren – und du bereits agentive Systeme produktiv laufen hast.“

Im nächsten Abschnitt zeige ich dir, wie du das alles konkret umsetzt: Und worauf du achten solltest, um Skalierung, Compliance und Praxistauglichkeit in Einklang zu bringen.

Welche Best Practices sichern eine erfolgreiche Implementierung von KI-Systemen?

Agentive KI funktioniert nicht mit Trial-and-Error. Sie braucht Struktur, Standards und ein Setup, das nicht nur technisch – sondern auch operativ funktioniert. Viele Unternehmen unterschätzen die operative Komplexität hinter KI-Projekten: fehlende Ownership, zu wenig Monitoring, kein Fokus auf Skalierung. Damit deine KI-Infrastruktur nicht zur Sackgasse, sondern zur Wachstumsbasis wird, zeigen wir dir hier unsere bewährten Best Practices.

Wie planen Unternehmen ihre Infrastrukturstrategien für langfristige KI-Nutzung?

Langfristig denken heißt: nicht nur für das nächste Projekt bauen, sondern . Erfolgreiche Unternehmen…

- Infrastruktur-Roadmap: die Business-Strategie und Tech-Stack verbindet

- … setzen auf , um neue Modelle und Tools einfach zu integrieren

- … vermeiden technische Schulden durch klare

Was wir empfehlen: Ein eigenes

Welche Rolle spielt die laufende Überwachung der Infrastruktur?

KI-Systeme sind lernende Systeme. Und genau deshalb musst du sie . Unsere Best Practices:

- Observability-Tools: wie Prometheus, Grafana, Datadog – für Echtzeitüberwachung von Ressourcen, Modellen und APIs

- Alerting-Systeme: für Anomalien im Modellverhalten, bei API-Zugriffen oder Ressourcenverbrauch

- CI/CD für KI: automatisierte Deployments, Testing und Rollbacks – nicht nur für Software, auch für KI-Modelle

Überwachung der Infrastruktur ist kein Add-on – sie ist Teil der Funktionalität. Denn nur wer sieht, was passiert, kann agieren, bevor’s kracht.

Wie stellen Unternehmen sicher, dass ihre Infrastruktur DSGVO-konform und zukunftssicher bleibt?

Datenschutz ist kein Showstopper, sondern ein Qualitätsmerkmal. – wo Daten sensibel, verhaltensbasiert und entscheidungsrelevant sind – musst du folgendes beachten:

- Datenflüsse transparent dokumentieren: von der Quelle bis zur Verarbeitung durch den KI-Agenten

- per Rollen- und Rechtekonzept, inklusive Audit-Funktionen

- hybride Modelle mit lokalem Hosting oder europäischer Cloud (z. b. IONOS, Scaleway)

Wir arbeiten nie mit Public GPT-Modellen, wenn sensible Daten im Spiel sind. Stattdessen setzen wir auf eigene Modelle, API-Isolierung und DSGVO-konforme Betriebsumgebungen. Denn Vertrauen ist die Grundlage jeder KI-Anwendung.

„Technologie bringt Geschwindigkeit. Governance bringt Sicherheit. Zusammen entsteht Zukunftsfähigkeit.“

Im letzten Abschnitt fassen wir zusammen:

Fazit: Ohne die richtige IT-Infrastruktur ist keine KI nachhaltig erfolgreich

Wenn du den Einsatz von KI in deinem Unternehmen ernst nimmst, führt kein Weg an einer leistungsfähigen, sicheren und skalierbaren IT-Infrastruktur vorbei. Sie ist nicht nur ein technisches Rückgrat – sie ist von entscheidender Bedeutung für die Genauigkeit deiner Algorithmen, die Verfügbarkeit deiner Systeme und die Wertschöpfung durch KI. Unternehmen müssen heute mehr denn je in die Entwicklung und Bereitstellung von Infrastrukturen investieren, die auf die speziellen Anforderungen zugeschnitten sind.

Dabei geht es nicht nur um Rechenleistung oder Speicher – sondern um die Fähigkeit, große Datenmengen zu verwalten, Modelle effizient zu trainieren und Ergebnisse sicher bereitzustellen. Unternehmen, die ihre eigene IT-Infrastruktur intelligent aufbauen oder gezielt mit Partnern erweitern, verschaffen sich einen echten Vorsprung.

Die Nutzung von KI entfaltet ihr Potenzial nur dann, wenn du auch die technischen und organisatorischen Anforderungen zu erfüllen verstehst – inklusive Datenschutz, Monitoring und Governance. Unternehmen müssen hier nicht nur Technologie einkaufen, sondern auch Fachwissen aufbauen und Prozesse mitgestalten.

Wir unterstützen Unternehmen dabei, genau diesen Übergang zu meistern: Von isolierten Pilotprojekten hin zur skalierbaren, sicheren und agentiven KI-Nutzung. Unsere Lösungen sind individuell, DSGVO-konform und zukunftsfähig – und setzen auf Flexibilität und Skalierbarkeit anstelle von kurzfristigen Lösungen.

Nur so lässt sich das Potenzial von KI wirklich ausschöpfen – für bessere , für schnellere

„Die Infrastruktur entscheidet, ob deine KI ein Werkzeug bleibt – oder dein Unternehmen transformiert.“

Wenn du bereit bist, die Weichen zu stellen, begleiten wir dich. Von der Analyse über die Konzeption bis zur deiner ganz eigenen KI-Umgebung. Damit du nicht nur dabei bist – sondern führst.